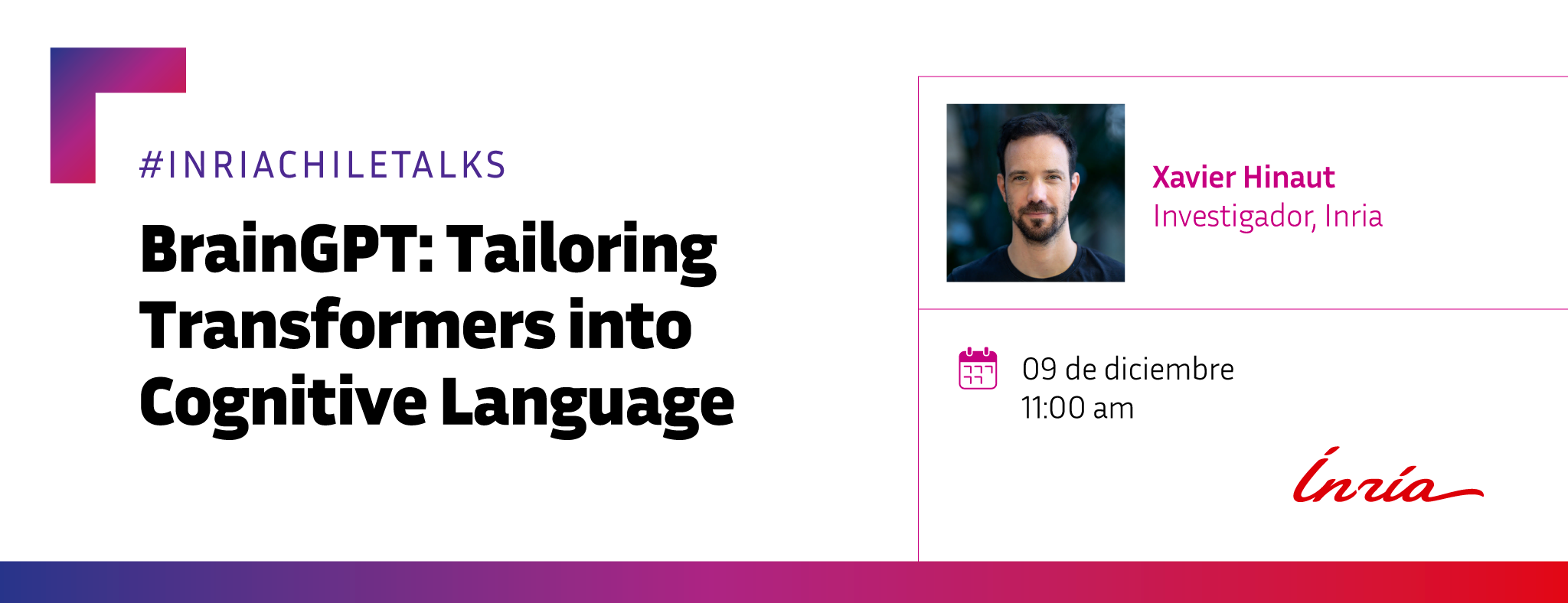

- Martes 09 de diciembre de 2025 - 11:00 am (hora de Santiago de Chile)

- Formato híbrido

- La charla será en inglés

- Expositor:

- Xavier Hinaut es investigador en aprendizaje automático bioinspirado y neurociencia computacional en Inria, en Burdeos, Francia, desde 2016.

Resumen

El lenguaje implica varios niveles de abstracción, desde pequeñas unidades de sonido como los fonemas hasta la comprensión contextual a nivel de frase. Los modelos de lenguaje grandes (LLM) han demostrado una impresionante capacidad para predecir los registros del cerebro humano. Por ejemplo, mientras un sujeto escucha un capítulo del libro de Harry Potter, los LLM pueden predecir partes de la actividad cerebral (registrada mediante resonancia magnética funcional o electroencefalografía) a nivel de fonema o palabra. Estos sorprendentes resultados se deben probablemente a sus arquitecturas jerárquicas y a los enormes datos de entrenamiento. A pesar de estas hazañas, difieren significativamente del funcionamiento de nuestro cerebro y aportan poca información sobre el procesamiento del lenguaje por parte del cerebro. Veremos cómo las redes neuronales recurrentes simples, como la computación por depósitos, pueden modelar la adquisición del lenguaje a partir de datos contextuales limitados y ambiguos mejor que las LSTM. A partir de estos resultados, en el proyecto BrainGPT exploramos diversas arquitecturas inspiradas tanto en los depósitos como en los LLM, combinando proyecciones aleatorias y mecanismos de atención para construir modelos que puedan entrenarse más rápidamente con menos datos y una mayor comprensión biológica.

Xavier Hinaut

Xavier Hinaut es investigador en aprendizaje automático bioinspirado y neurociencia computacional en Inria, en Burdeos, Francia, desde 2016.

Es ingeniero y máster de la Universidad Tecnológica de Compiègne (UTC), Francia, 2008, master en Ciencias Cognitivas e Inteligencia Artificial en la École Pratique des Hautes Études (EPHE), Francia, en 2019, y un doctorado en la Universidad de Lyon, Francia, en 2013. Es presidente del grupo de trabajo del IEEE CIS Task Force on Reservoir Computing. Su trabajo se encuentra en la frontera de las neurociencias, el aprendizaje automático, la robótica y la lingüística: desde el modelado del procesamiento de frases humanas hasta el análisis del canto de los pájaros y sus correlatos neuronales. Utiliza tanto reservorios para el aprendizaje automático (por ejemplo, la clasificación del canto de los pájaros) como modelos (por ejemplo, modelos sensoriomotores de cómo los pájaros aprenden a cantar). Dirige el proyecto «DeepPool» de la Agencia Nacional de Investigación de Francia (ANR) sobre el modelado de frases humanas con arquitecturas Deep Reservoirs y la acción exploratoria «BrainGPT» de Inria sobre Reservoir Transformers. Dirige el desarrollo de ReservoirPy: la biblioteca Python más actualizada para la computación de reservorios. https://github.com/reservoirpy/reservoirpy También participa en actividades de divulgación, en particular organizando hackatones como www.hack1robo.fr, de los que han surgido proyectos creativos que vinculan la IA y el arte (proyecto ReMi sobre generadores de MIDI y sonidos, al que ahora le sigue la startup Allendia).